Introducción

Actualmente, podrás observar imágenes creadas por algoritmos como los de Stable Diffusion. Sin embargo, crear videos con ayuda de IA es un proceso mucho más difícil. Como alguien que labora en una compañía de producción de medios, estoy confiadamente seguro de que la creatividad generada por IA aún no se encuentra a la altura de calidad necesaria para el uso generalizado para la creación de videos de difusión.

Hay una brecha interminable de diferencia entre los videos generados por IA y los estándares de la industria. La Stable Diffusion no solo se limita a producir imágenes estáticas, sino que también tiene el potencial de crear videos con IA visualmente impresionantes con la ayuda de ciertas herramientas y extensiones. Aquí hay una guía fácil para crear marcos para un GIF animado o un video de Stable Diffusion.

En este artículo

¿La Stable Diffusion puede generar videos?

Sí, es posible crear videos o archivos GIF con Stable Diffusion. Las últimas funciones de img2img pueden crear videos cortos o archivos GIF que se asemejen a videos. Además, la tecnología IA rápidamente puede proveer marcos animados para el video.

Adicionalmente, hay herramientas especializadas disponibles para la creación de videos haciendo uso de la plataforma de Stable Diffusion. Estas herramientas pueden ser usadas para generar videos MP4 con la ayuda de la interfaz de usuario de la web.

¿La Stable Diffusion es buena?

Un generador de video de Stable Diffusion es una herramienta excepcional para producir realistas e impresionantes imágenes. A pesar de que su utilización puede presentar inconvenientes, las ventajas exceden cualquier impacto negativo. Debido a su conveniencia, versatilidad y resultados asombrosos, la Stable Diffusion es esencial para cualquier aficionado de atractivos visuales.

La Stable Diffusion es un gran recurso para aquellos que buscan expandir sus capacidades artísticas. Puede ayudarte a encontrar inspiración para nuevos proyectos o para explorar diferentes estilos y técnicas visuales.

Su interfaz amigable de usuario te permite personalizar las imágenes que creas para ajustarlas según tus especificaciones.

No necesitas tener experiencia de artista para tomar ventaja de sus capacidades, es fácil de usar a pesar de tu nivel de habilidad. Con la Stable Diffusion, puedes utilizar tu creatividad para producir impresionantes imágenes y diseños para presumir con orgullo.

¿Cómo funciona la Stable Diffusion?

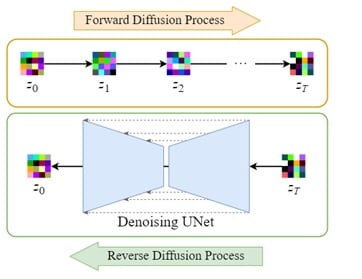

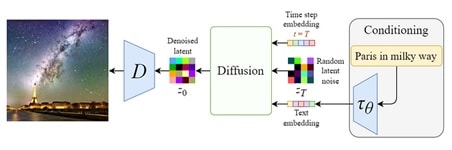

El concepto central del generador de imágenes a través del modelo de difusión se basa en el hecho de que los modelos avanzados de visión artificial pueden ser entrenados con suficientes datos. La Stable Diffusion ofrece un poderoso enfoque para este problema utilizando un algoritmo para generar una imagen basada en parámetros específicos.

El algoritmo de Stable Diffusion inicia el proceso de creación de video con una imagen con ruido aleatorio y continuo refinado utilizando una técnica de difusión especial. El resultado es muy atractivo, una creación de alta resolución que luce como si fuera hecho por un artista experto. Aquí está el proceso:

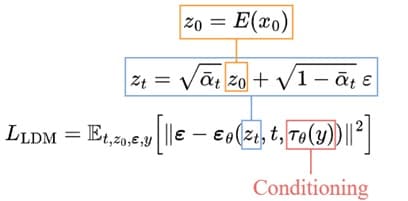

1. Salida al espacio latente:

El proceso comienza entrenando un autocodificador para codificar las imágenes en representaciones latentes de menor dimensión. Para esto puedes utilizar un codificador ya entrenado, para convertir las imágenes originales en versiones comprimidas más pequeñas. El decodificador entrenado puede reconstruir la imagen original desde la información latente.

2. Difusión latente:

El proceso de difusión hacia adelante implica agregar ruido a los datos latentes codificados, mientras que el proceso de difusión inversa implica eliminar este ruido de los mismos datos. Asegura que la imagen pueda ser transformada a su forma original.

3. Acondicionamiento:

El modelo de generación de video de Stable Diffusion aprovecha la capacidad de generar imágenes a partir de indicaciones textuales al aumentar la eliminación de ruido U-Net con un mecanismo de atención cruzada.

Se realiza proporcionando el modelo interno con entradas condicionales, como incrustaciones de texto generadas por un modelo de lenguaje como BERT, CLIP y otras entradas espaciales como imágenes o mapas. Dependiendo del tipo de entrada condicional, es mapeado dentro de la U-Net a través de la capa de Atención o agregado a través de la concatenación.

4. Entrenamiento y muestreo:

La meta del entrenamiento es similar al modelo básico de difusión con unas pocas alteraciones: toma datos latentes zₜ en lugar de la imagen xₜ. U-Net también incluye una entrada de condicionamiento 𝜏θ(y). El procedimiento de eliminación es mucho más rápido, ya que los datos latentes son mucho más pequeños que la foto inicial.

¿Cómo crear un video con Stable Diffusion?

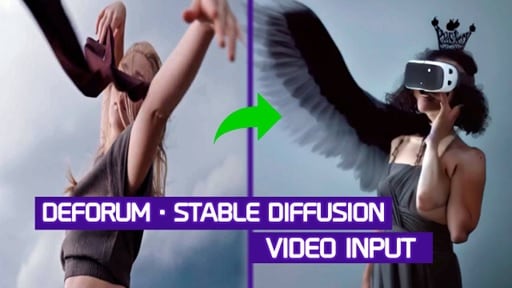

La Stable Diffusion de Deforum es una versión especializada, diseñada para crear videoclips y transiciones utilizando imágenes generadas por Stable Diffusion. Personas con cualquier nivel de habilidad o experiencia pueden utilizar esta herramienta de software de código abierto impulsado por la comunidad.

Los desarrolladores siempre estarán dispuestos a aceptar nuevas contribuciones en caso de que te encuentres interesado en participar en el proyecto. El pipeline para la generación de videos a través de la Stable Diffusion deforum te permite crear simulaciones completas sin tener que utilizar tu GPU.

• Genera un video utilizando deforum

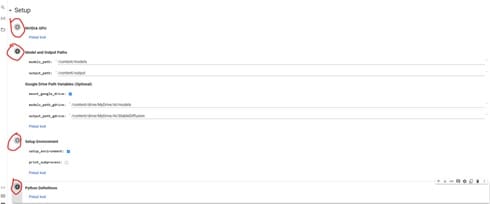

Para copiar el video generado por Stable Diffusion deforum v0.5 a tu Google Drive, haz clic en el botón "Copiar a Drive". Una vez hecho, se te enviará una nueva copia del cuaderno Colab a tu propio Google Drive y luego podrás cerrar el original, ya que no lo necesitarás más.

• Paso 1: instala la extensión de deforum

Actualmente, puedes aprovechar al máximo Google Colab y conectarlo a una GPU externa. Ten en cuenta de que recibes algunos créditos complementarios por Google Colab; sin embargo, si los agotas deberás compras más o esperar unos días para que sean restablecidos.

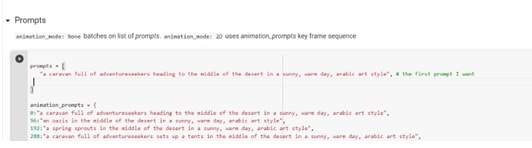

• Paso 2: escribe tus indicaciones

El uso de modelos de Stable Diffusion (o algún otro LLM) para generar videos para la ingeniería o el desarrollo de nuestras técnicas de comunicación es cada vez más importante en la actualidad.

Se recomienda proporcionar indicaciones detalladas y específicas cuando se realiza la generación de imágenes para lograr los efectos deseados. También es importante para proporcionar una vista previa de cualquier configuración de animación o efecto deseado, tales como iluminación, hora del día, estilo artístico o referencia cultural.

Es importante evitar títulos de obras y descartar nombres de artistas, pero para algunos proyectos puede producir resultados interesantes. Cuando estás generando una animación, antes de comenzar, proporciona siempre la primera indicación y alguno otro adicional.

Primero prueba las indicaciones y después utiliza las que mejor funcionan para la animación final. Con las técnicas apropiadas, los creadores pueden lograr los efectos deseados para una animación exitosa.

• Paso 3: ajusta las configuraciones del deforum

Se sugiere utilizar la opción override_with_file en la generación de videos por medio de Stable Diffusion, de este modo tus configuraciones siempre serán guardadas y pueden ser reutilizadas, compartidas o revertidas. Para imágenes 9:16 intenta 448 x 706; para forma vertical 706 x 448 y para el cuadrado 512 x 512.

En la configuración de muestreo, ingresa un número en la línea inicial en caso de que deseas una imagen determinada o -1 para una aleatoria. Para el valor del paso, se sugiere un rango entre 50 y 60. Finalmente, el valor de la escala puede ser configurada entre 7 y 12.

• Paso 4: genera tu video

El paso final después de generar los videos es descargar las imágenes e ingresarlas a un programa de edición adecuada de video antes de poder renderizar el video. Un programa gratuito para esto es Davinci Resolve 18, el cual ofrece una variedad de funciones que te permitirán tener más control sobre el producto final.

Como alternativa, puede ser utilizado el código de "crear videos desde fotogramas" sin embargo, no siempre podría tener los resultados deseados.

¿Cómo escribir indicaciones de Stable Diffusion?

Si has utilizado alguna herramienta de generación de imagen por IA como Stable Diffusion, DALL- E o MidJourney, podrás entender lo esencial que es la redacción correcta cuando colocas una indicación. Una indicación precisa y completa puede convertir cualquier idea en una imagen sorprendente, mientras que una frase vaga puede resultar en una imagen bizarra e inquietante. Aquí te dejamos algunos consejos:

1. Sé específico: la generación de video por Stable Diffusion se desarrolla bien cuando se le proporcionan instrucciones concretas, en comparación con MidJournet, el cual es más abierto (sin límites fijos). Para generar paisajes con Stable Diffusion, deberás ser detallado en tus instrucciones, utilizando palabras que describan con mejor precisión la imagen que deseas buscar.

Experimentando con frases diferentes y viendo qué tipo de resultados producen. Resulta benéfico observar cómo un cambio de pocas palabras puede cambiar drásticamente una imagen y después poder incorporarlas a las indicaciones para lograr el resultado deseado.

2. Asegúrate del estilo artístico y la creatividad: además de indicar el contenido de la imagen que deseas, también debes especificar el estilo que deseas. Por ejemplo, si estás en búsqueda de una apariencia similar a la de una pintura acrílica, tu indicación deberá decir algo como "nombre, pintura acrílica" o "nombre, estilo acrílico".

Esta fórmula ofrece una mejor oportunidad de acercarse al estilo que estás buscando. La Stable Diffusion tiene varias apariencias y estilos como dibujos a lápiz, modelos de arcilla e incluso renderizaciones en 3D con Unreal Engine.

3. Incluye el nombre del artista para mayor claridad: la Stable Diffusion es una gran opción si estás buscando evocar el estilo de un artista en específico dentro de una obra. Es una herramienta poderosa que si le proporcionas la indicación correcta realmente puede capturar la esencia de un artista en particular.

Incluso puedes combinar diferentes artistas para producir una fusión única entre dos estilos. Este tipo de experimentación artística puede producir resultados emocionantes e inesperados, así que no temas intentar generar videos por difusión.

4. Analiza tus palabras clave: Si necesitas enfatizar cierta palabra clave en la indicación, la Stable Diffusion proporciona opciones de ponderación. Esta función te permite asignar mayor importancia a algunas palabras de otras con el fin de poder obtener resultados más precisos. Es especialmente útil cuando el resultado es casi correcto pero podría beneficiarse aún más si la atención se enfoca en un término en específico.

5. Otras referencias: recientemente ha habido un gran aumento en la cantidad de arte por IA disponible en línea. Todos están produciendo estos tipos de piezas y muchas de estas creaciones incluyen palabras clave o fórmulas en su generación. Esto indica que múltiples imágenes generadas por usuarios a través del internet, fácilmente podrían llegar a ser millones.

Configuraciones adicionales de técnicas para generar indicaciones:

Crear una indicación efectiva es la parte más difícil de utilizar Stable Diffusion, sin embargo, ajustando otras configuraciones podrías impactar considerablemente en el resultado.

- CFG: Este parámetro establece el nivel de confidencia que tiene la IA de Stable Diffusion para generar una respuesta que refleje con precisión tus indicaciones. Incrementar el valor hará que la IA genere indicaciones más fieles, mientras que reducir el valor le brindara más margen para ejercer con autonomía el texto generado. Prueba diferentes valores para ver el rango de resultados que puedes obtener.

- Enfoque de muestreo: la imagen se limpia de la interferencia y es transformada en patrones identificables utilizando una variedad de algoritmos como Euler_a, k_LMS y PLMS, los cuales son frecuentemente utilizados para generar videos por medio de Stable Diffusion.

- Etapas de muestreo: el número de iteraciones para llegar a la versión final de una imagen puede variar. Generalmente, pocos pasos producen resultados satisfactorios, mientras que un mayor número de pasos pueden no conducir a una mejora adicional. Frecuentemente, es recomendado comenzar con pocos pasos, aumentando gradualmente en caso de ser necesario. Generalmente, ir más allá de las 150 iteraciones no brinda como resultado alguna mejora adicional.

Conclusión

La creación de un video en tiempo real por medio de la Stable Diffusion puede ser bastante laborioso y consumir mucho tiempo. Sin embargo, a medida que la tecnología avanza, se espera que sea más simple poder crear videos por medio de la Stable Diffusion, así como lo es ahora la generación de imágenes. Sin embargo, hasta que se logre dicho avance, los usuarios deben aprovechar de varias sub-herramientas y comandos que podrían no ser comprensibles para todos.

Preguntas frecuentes

-

¿Puedes animar por medio de la Stable Diffusion?

La creación de animaciones puede ser hecha de varias maneras. Estabilidad IA permite a los usuarios utilizar modelos de Stable Diffusion para la creación de animaciones, tales como: Stable Diffusion 2.0 y Stable Diffusion xl. Además, los usuarios pueden utilizar el punto final de la animación para acceder a las plantillas prefabricadas, lo que les permite crear animaciones de forma rápida y en grandes cantidades. -

¿Qué puede generar la Stable Diffusion?

La Stable Diffusion es un generador de imágenes por IA que puede ser personalizada a tu gusto. Tiene una plataforma de código abierto que te permite crear tus propios conjuntos de datos y ajustar las imágenes generadas. Además, puedes entrenar tus modelos para crear imágenes que se ajusten a tus preferencias. -

¿La Stable Diffusion es solo para imágenes?

La Stable Diffusion es un método que permite la creación de imágenes con base en descripciones de texto. Es una opción superior en comparación a Mid-Journey y DALLE-2, ya que puede traducir con precisión el texto a imágenes. Esto se logra a través de algoritmos sofisticados y a una red neuronal convolucional, la cual convierte el contenido escrito a la imagen correspondiente.